Do primeiro computador do mundo até 2024: uma breve linha do tempo!

Desde o primeiro computador do mundo, muita coisa evoluiu, rendendo muita história!

Se o século XIX foi notável pelas primeiras Revoluções Industriais, os séculos XX e XXI testemunharam a chegada do primeiro computador, marcando uma evolução significativa desde então. Embora os primórdios dos computadores tenham ocorrido no século XIX, foi na primeira metade do século XX que surgiu a primeira "supercalculadora", uma máquina capaz de realizar cálculos de maneira mais eficiente do que os humanos.

Essas inovações deram origem aos primeiros computadores, os quais se desenvolveram ao longo do tempo e agora são utilizados para diversas finalidades, incluindo trabalho, estudo e entretenimento. Similar à evolução da televisão (um tema cuja leitura também é recomendada), é relevante destacar que o computador ainda não atingiu seu primeiro centenário.

O aspecto mais fascinante é que, mesmo estando a cerca de 15 anos de completar o século de existência, há diversas opções promissoras para o futuro dessas máquinas. Além de abordar os avanços e revoluções na tecnologia, também exploraremos o que ainda pode mudar e surpreender nesse breve intervalo de tempo.

- Quer aprender mais sobre informática? Descubra o que é sistema operacional, como descobrir o modelo do seu notebook e também como descobrir as configurações!

- Precisa de um notebook bom e moderno? Veja a lista de melhores notebooks do ano e garanta um modelo perfeito para o seu uso!

Do primeiro computador até hoje: um resumo

Supercalculadoras: precursores do primeiro computador do mundo

O matemático Charles Babbage concebeu o conceito do primeiro computador digital no século XIX. Ele também introduziu a ideia da primeira memória RAM, um dispositivo para armazenar dados temporários e utilizá-los futuramente. Denominada "Difference Engine" (Máquina Diferencial em inglês), a máquina proposta empregaria rodas dentadas para realizar cálculos.

Embora a Difference Engine fosse considerada um conceito de computador mecânico, a Analytical Engine (Máquina Analítica em inglês) apresentava semelhanças com os computadores modernos. Utilizando instruções por meio de cartões perfurados, essa máquina seria capaz de executar cálculos mais complexos do que seu antecessor.

Ambas, a Difference Engine e a Analytical Engine, não foram reconhecidas como os primeiros computadores devido a um motivo simples: não foram construídas, apenas idealizadas. No entanto, a Analytical Engine serviu como a base para os computadores contemporâneos.

Ada Lovelace: a primeira programadora

A ideia de utilizar cartões perfurados para inserir instruções na Analytical Engine não partiu de Babbage, mas sim de Ada Lovelace. Essa concepção foi inspirada na máquina de tear de Jacquard, que empregava tais cartões para criar padrões nos tecidos.

Essa inovação ampliou o conceito da Analytical Engine, inicialmente voltado apenas para números, possibilitando que ela também criasse imagens. Antes mesmo da existência do primeiro computador, Ada Lovelace já vislumbrava esse dispositivo como uma ferramenta multifuncional.

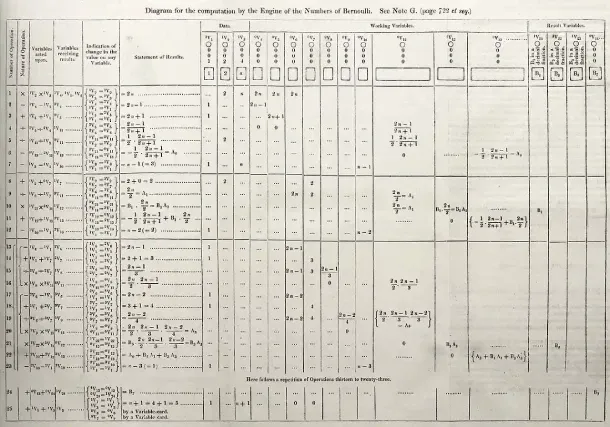

O primeiro algoritmo originou-se de uma apresentação de Babbage sobre a Analytical Engine. Após essa exposição, o engenheiro italiano Luigi Menabrea publicou um artigo em francês sobre a máquina. Ao traduzir e complementar o artigo em inglês com suas próprias notas mais extensas que a publicação original, Ada Lovelace criou a primeira sequência de cálculos exclusivamente destinada a um computador. O objetivo era calcular os números de Bernoulli, uma famosa sequência matemática.

A Jornada para o primeiro computador do mundo: desbravando inovações

Se o século XIX testemunhou as sementes das ideias de Babbage e Ada Lovelace para o primeiro computador, foi apenas após 100 anos que essa visão se concretizou. Na década de 1930, os Estados Unidos, Inglaterra e Japão lideravam pesquisas e projetos, moldando o futuro dos computadores.

Guerra e inovação: um capítulo decisivo

O período pré-guerra e os anos da Segunda Guerra Mundial marcaram a transformação dos projetos de computadores em realidade. Destacamos as trajetórias dos Estados Unidos e da Inglaterra nesse cenário.

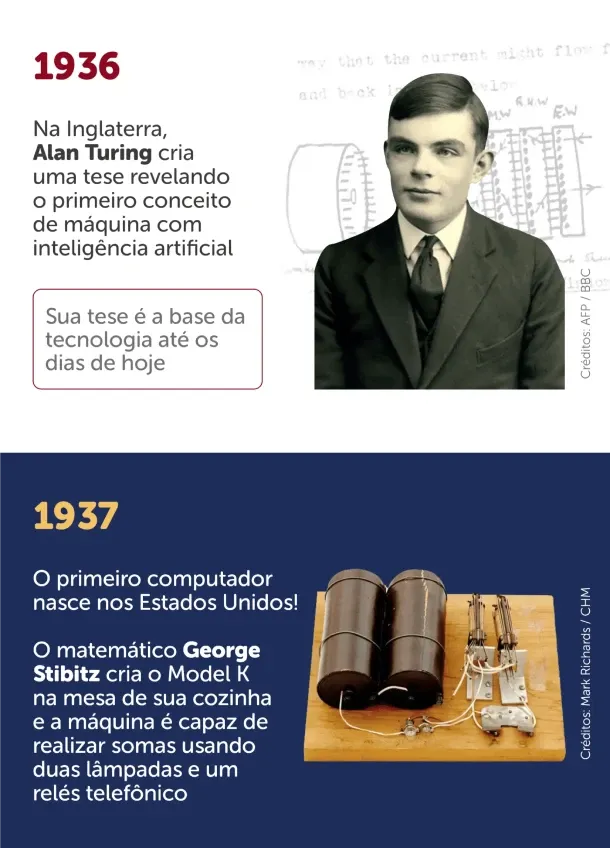

Primeiro computador na Inglaterra: quebrando códigos com Alan Turing

Alan Turing, figura-chave não apenas na Segunda Guerra Mundial, destacou-se por seu serviço ao quebrar o Enigma, sistema de códigos nazista. Em 1936, sua tese introduziu a ideia de uma máquina capaz de resolver problemas, expandindo o conceito anterior de máquinas orientadas por comandos humanos.

Após servir como criptógrafo durante a guerra, Turing concretizou seu conceito em 1940, construindo a máquina "Victory". Essa máquina decifrou códigos nazistas, fornecendo aos Aliados informações cruciais para a vitória. Esse marco não só moldou a evolução subsequente dos computadores, mas também inspirou o filme "O Jogo da Imitação".

Primeiro computador remoto nos EUA: a criação de George Stibitz

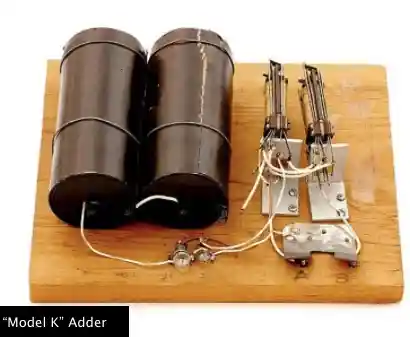

Nos Estados Unidos, o matemático George Stibitz é creditado pela criação do primeiro computador. O Model K, desenvolvido em sua própria cozinha, utilizava lâmpadas e relés telefônicos para realizar cálculos binários de soma. Stibitz descobriu a versatilidade dos relés telefônicos, explorando sua capacidade para operações sequenciais, iluminando o caminho para futuros avanços.

Esses capítulos da história, embora distintos em geografia, convergem na determinação de pioneiros que moldaram o advento dos computadores. Seja quebrando códigos cruciais ou realizando cálculos binários inovadores, esses momentos foram essenciais para a construção do mundo digital que conhecemos hoje.

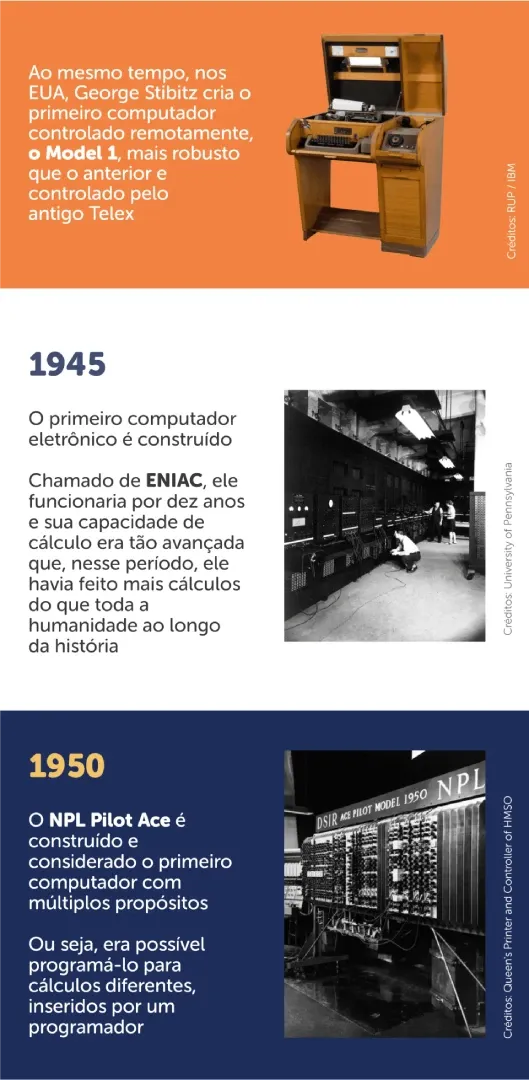

A evolução do Model K para o Model 1

Apesar de sua recepção inicial não ressaltar sua grandiosidade, a máquina de Stibitz serviu como alicerce para seu próximo feito computacional. Intitulada Model 1, essa máquina foi concluída em 1940, coincidindo com a criação da "Victory" de Alan Turing.

Model 1: avanços significativos

Incorporando os princípios do modelo caseiro, o Model 1 representou uma evolução notável. Capaz de realizar operações avançadas, como multiplicação e divisão, e com a capacidade futura de somar e subtrair, essa máquina era uma versão mais sofisticada.

Enquanto o Model K dependia de um relé telefônico conectado a duas lâmpadas, o Model 1 ostentava cerca de 450 relés binários e oito painéis. Além disso, empregava relés multipolares para armazenar temporariamente números utilizados nos cálculos.

Expansão para telecomunicações

Stibitz também deixou sua marca na arena de redes e telefonia. O Model 1, pioneiro nesse aspecto, podia ser controlado remotamente por meio de uma linha telefônica e um teletipo. No Brasil, esse dispositivo era conhecido como o antigo Telex, demonstrando a visão inovadora de Stibitz não apenas na computação, mas também na conectividade à distância.

Antes de concluirmos essa extensa linha do tempo que conta a trajetória desde o primeiro computador do mundo, é crucial destacar que em 1939, um marco significativo ocorreu no cenário da informática.

Nesse ano, surgiu uma das pioneiras empresas do setor que perdura até os dias atuais: a Hewlett-Packard, agora reconhecida pela abreviação HP, mundialmente renomada por suas impressoras multifuncionais.

Você sabia que a própria denominação "computador" originou-se de sua capacidade intrínseca de realizar cálculos? Como explicado anteriormente, a concepção inicial dessa máquina visava superar a habilidade humana em efetuar cálculos. No entanto, no século XIX, já se percebia o potencial de transformar o computador em uma ferramenta multifuncional.

Embora o computador mantenha sua essência como uma máquina de cálculos, a evolução que o elevou a um dispositivo muito mais avançado do que uma simples supercalculadora foi a introdução de programas, elaborados por meio de algoritmos.

São esses programas que permitem que o computador realize diversas atividades, como navegar na internet, editar imagens e vídeos, redigir textos de maneira organizada e proporcionar entretenimento. No entanto, antes da presença desses programas, as máquinas tinham propósitos específicos. O computador concebido por Alan Turing, por exemplo, tinha como única função quebrar códigos militares inimigos diariamente.

Além disso, esses computadores primitivos possuíam muitos componentes mecânicos, o que tornava os processos de cálculo lentos. Entretanto, esse cenário passou por uma revolução com o advento do ENIAC, considerado o primeiro computador predominantemente eletrônico.

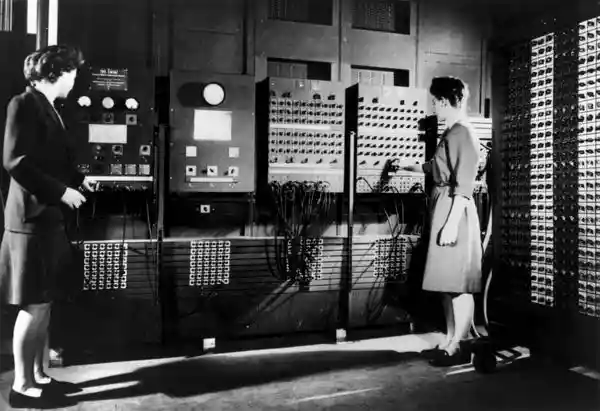

Desenvolvido para realizar cálculos balísticos durante a Segunda Guerra Mundial, o ENIAC possuía a capacidade de desempenhar outras funções, graças à sua capacidade de receber instruções por meio de algoritmos. Além de sua complexidade, era uma máquina gigantesca, exigindo uma sala dedicada e um sistema de ventilação para dissipar o calor gerado.

O ENIAC era composto por milhares de capacitores, relés, interruptores e tubos de vácuo. No entanto, destacava-se como a máquina de cálculos mais veloz já inventada. Em apenas uma década de existência, estima-se que esse primeiro computador eletrônico já havia realizado mais cálculos do que toda a história da humanidade até então.

Evolução rumo ao computador pessoal: da programação flexível ao IBM PC

Em um avanço posterior, o NPL Pilot Ace foi concebido com a capacidade de incorporar novas funções por meio da inclusão de códigos de programação, eliminando a necessidade de acréscimo de componentes físicos.

Progressivamente, ao longo dos anos, o computador foi moldando sua forma atual, destacando-se com a criação do primeiro teclado e os primeiros modelos análogos ao computador pessoal. No entanto, esses avanços ainda eram restritos a empresas e ao setor militar.

Durante as décadas de 50 e 60, os computadores evoluíram, ampliando suas capacidades de cálculo. Contudo, permaneciam restritos às esferas militares e corporativas. Foi apenas no início dos anos 70 que ocorreu a revolução do primeiro computador pessoal.

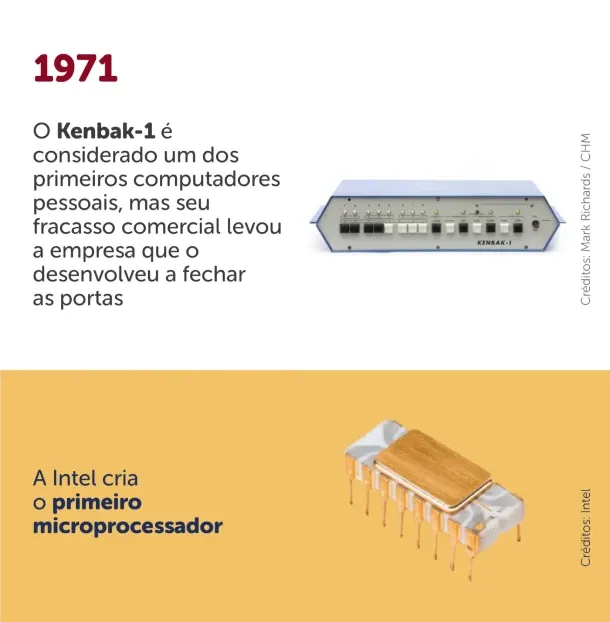

O Kenbak-1, um dos pioneiros na categoria, apresentava modestos 256 bytes de memória e utilizava interruptores de luz para operar. Lançado em 1971 com o custo de 750 dólares, não obteve grande êxito, vendendo apenas 40 unidades e levando ao fechamento da Kenbak.

Apesar disso, desempenhou um papel importante como um dos primeiros computadores pessoais, que podiam integrar-se ao ambiente doméstico sem a necessidade de um espaço exclusivo. Nesse mesmo ano, um marco significativo foi alcançado com a criação do Intel 4004, o primeiro microprocessador do mundo, inicialmente empregado em computadores corporativos que ocupavam salas inteiras.

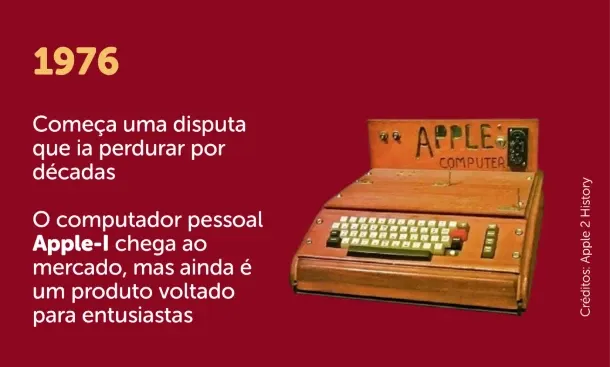

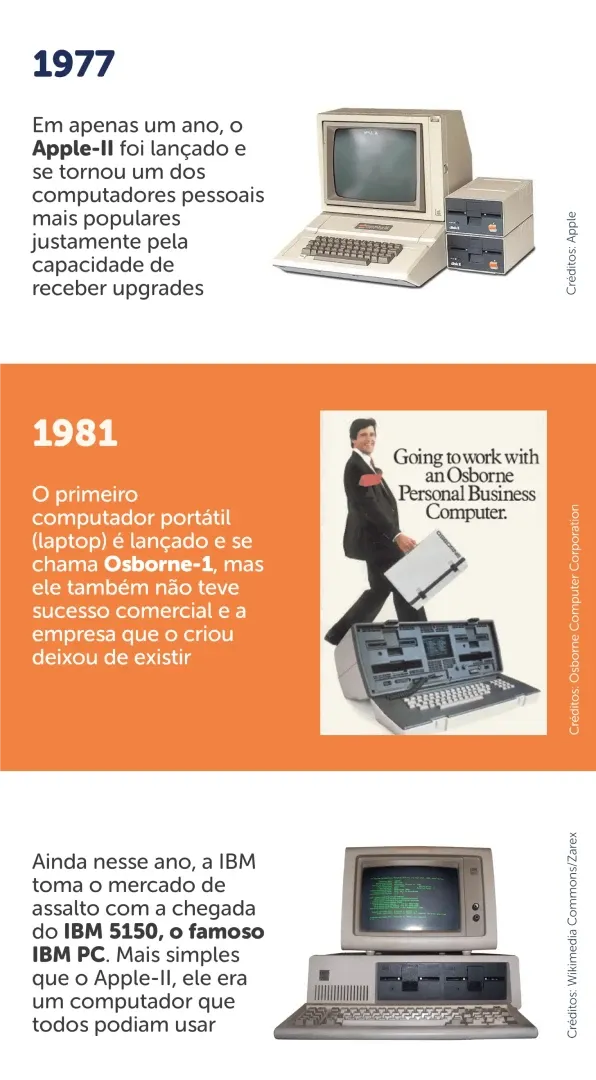

O protótipo do PC moderno surgiu em 1973, desenvolvido pela IBM, apresentando uma tela CRT, um teclado e uma entrada para fitas cassete. Contudo, antes da chegada do IBM PC, a Apple, fundada por Steve Wozniak e Steve Jobs, fez sua entrada no mercado com o Apple-I, lançado em 1976. Este foi o precursor de um dos computadores pessoais mais populares, o Apple-II, lançado no ano seguinte.

O Apple-II permaneceu relevante por possibilitar a adição de periféricos e a troca de peças, conferindo ao computador uma característica personalizável, semelhante à abordagem adotada pelos melhores computadores contemporâneos.

Outro aspecto marcante do Apple-II foi abrir caminho para várias empresas de tecnologia competirem nesse mercado. Essa era foi marcada pelo surgimento de computadores clássicos como MSX, Commodore 64, ZX Spectrum e Amiga, entre outros.

Apesar desses computadores atenderem principalmente a entusiastas de tecnologia na época, havia um espaço significativo no mercado que foi preenchido por uma rival importante da Apple: a IBM.

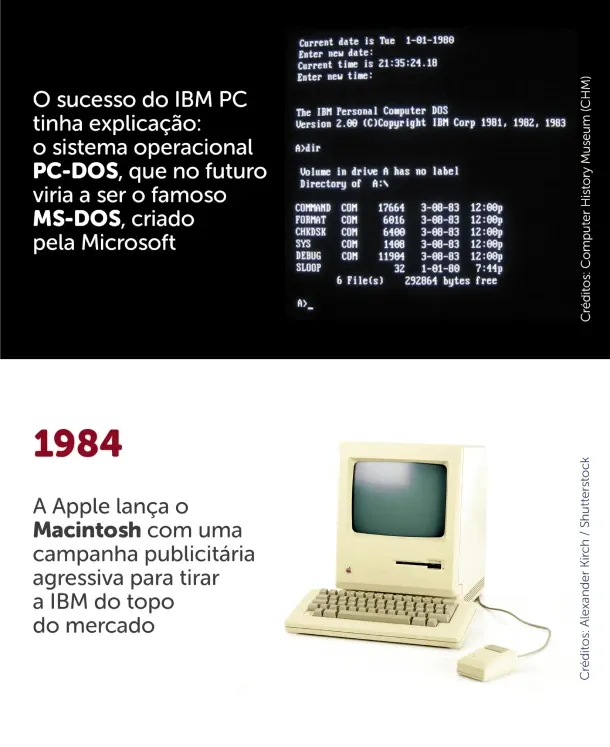

Em 1981, a IBM introduziu o conceito de computador pessoal, conhecido até hoje pela sigla PC. Diferenciando-se do produto da Apple, considerado destinado a entusiastas de tecnologia, a proposta do IBM 5150, ou IBM PC, era justamente o oposto: ser um computador acessível a todos. O objetivo era democratizar o acesso aos computadores, consolidar um novo mercado e criar uma nova necessidade para os consumidores.

Para isso, contaram com a colaboração de uma pequena empresa que viria a se tornar uma gigante tecnológica contemporânea: a Microsoft de Bill Gates. O sistema operacional do IBM PC também se tornaria um dos mais apreciados, cultuados e lembrados até hoje, mesmo para aqueles que cresceram com o Windows: o PC-DOS, desenvolvido especificamente para o IBM PC e posteriormente comercializado pela Microsoft como MS-DOS. Se você utiliza o Windows como sistema operacional, ainda encontrará a mesma interface no seu PC hoje: o prompt de comando.

O êxito do IBM PC levou a Apple a considerar outro mercado, em vez de focar exclusivamente nos entusiastas. Uma vez que o Apple-II era um sistema muito aberto, exigia um conhecimento substancial por parte dos usuários para ser utilizado com eficácia.

Dois anos após o lançamento do IBM PC, a Apple entrou na competição ao lançar o primeiro Macintosh, em uma campanha publicitária intensa durante o Super Bowl de 1984. A propaganda acusava a IBM de monopolizar o mercado e usar seus computadores como uma espécie de "Big Brother", fazendo uma alusão à distopia criada no livro "1984", de George Orwell.

O Macintosh seria o primeiro computador criado com a filosofia que Steve Jobs estenderia para a Apple e que ainda é um conceito muito presente em produtos como o iPhone e o iPad: o foco em proporcionar a melhor experiência ao usuário.

Embora a história da informática tenha seu início no século XIX, somente na segunda metade do século passado a computação começou a ganhar espaço no Brasil. Historicamente, o primeiro computador no país foi o Patinho Feio, construído na Escola Politécnica da USP em 1972, resultado de um contrato entre a instituição e a Marinha brasileira.

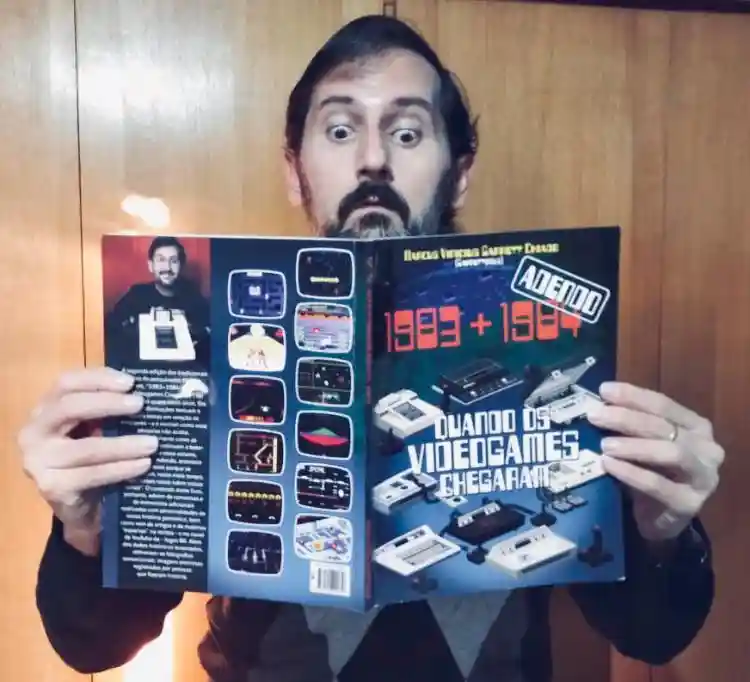

Os computadores pessoais começaram a ser introduzidos no mercado brasileiro a partir de 1981, quando brasileiros que viajavam para países com mercados já estabelecidos, como Estados Unidos e Japão, os trouxeram para o Brasil. As primeiras empresas brasileiras de informática, no entanto, começaram a surgir na década de 1980, impulsionadas por uma iniciativa de reserva de mercado local implementada no Brasil. Promulgada em 1984, essa iniciativa proibia a importação de produtos de informática para o Brasil, assim como a estabelecimento de empresas estrangeiras no país. As restrições, inclusive, não se limitavam apenas aos eletrônicos.

Você sabia que devido a políticas protecionistas, crianças das décadas de 1980 e 1990 cresceram com Comandos em Ação e Banco Imobiliário, em vez de G.I. Joe e Monopoly? Mesmo após o fim dessas políticas, ambos os nomes permaneceram tão marcantes que se estabeleceram, embora os nomes originais pudessem ser utilizados.

A introdução dos computadores pessoais no mercado brasileiro

O pesquisador que testemunhou a introdução dos primeiros computadores pessoais no Brasil compartilhou que essas máquinas eram, essencialmente, "cópias dos computadores trazidos de fora".

Em uma conversa com a equipe do Zoom, ele detalhou que as empresas de informática nacionais que estavam se estabelecendo no país obtinham acesso a computadores como os já mencionados Apple-II e TRS-80 e aplicavam engenharia reversa. Em outras palavras, desmontavam os computadores para aprender sobre sua fabricação.

A partir desse conhecimento, fabricavam clones de computadores, seguindo o mesmo método, mas fazendo algumas modificações, como "gabinete, nome e cor, mas, essencialmente, eram todos cópias. A Dismac, por exemplo, lançou um clone do TRS-80 em 1980. A Microdigital lançou clones do ZX80 e ZX81 em 1981 e 1982. A Nova Eletrônica, do grupo Filcres, lançou o NE Z80 e depois o NE Z8000."

No entanto, serem clones trouxe desafios, pois além do preço elevado, apresentavam desempenho inferior aos computadores originais. Vale ressaltar que esses clones eram de computadores que já estavam obsoletos na época. Assim, apesar do crescimento do mercado de informática, a qualidade dos equipamentos não era a melhor. Ainda assim, os efeitos da política de reserva de mercado não foram completamente negativos, conforme destacou o autor.

"A ideia era criar essa tecnologia no Brasil, por isso a 'proteção' contra coisas que vinham de fora. Era como se o Brasil estivesse 'blindado' para os equipamentos e as empresas do estrangeiro. Mas muitos engenheiros e técnicos se formaram com esse boom da microinformática pessoal no Brasil na época."

Outro ponto relevante é que esse fenômeno também se manifestou na indústria de videogames. O NES, primeiro console de mesa da Nintendo, chegou ao Brasil por meio de clones, como o Phantom System e o Dynavision, entre outros. Somente em 1992, com o fim da política de reserva de mercado, o país passou a ter representações oficiais, resultando na chegada do Super Nintendo, oficialmente, um dos videogames mais queridos e nostálgicos da história brasileira e mundial.

O surgimento do Notebook: o inicio da mobilidade

A história do primeiro notebook se entrelaça com a do primeiro computador pessoal, com eventos importantes ocorrendo quase simultaneamente, principalmente ao longo da década de 1980, uma das mais movimentadas na história da Informática.

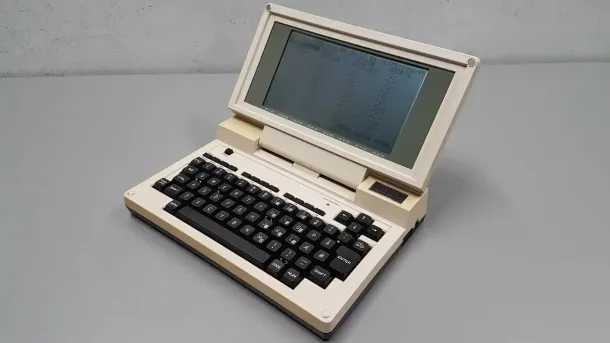

O Osborne-1 é reconhecido hoje como o primeiro laptop, lançado em 1981, antes mesmo do PC da IBM. Conceitos que o antecederam, especialmente no final da década de 1970, foram apresentados por empresas como Xerox, Epson, Microsoft e Toshiba.

Alguns argumentam que o próprio IBM PC de 1982 poderia ser considerado um computador portátil. No entanto, tanto o IBM PC quanto o Osborne-1 enfrentavam um desafio em relação à portabilidade: eram pesados demais e raramente podiam ser usados no colo, contrariando a proposta de um laptop.

O pioneirismo do TRS-80 Model 200, fabricado pela Radio Shack, marcou a introdução do primeiro laptop no formato "caderno", que se tornou o padrão até os dias atuais. Seu lançamento em 1985 estabeleceu um padrão que foi seguido por praticamente todos os concorrentes, os quais aprimoraram as funcionalidades ao longo do tempo, incorporando elementos como a inclusão de drives para CDs e, naturalmente, maior poder computacional.

Embora, inicialmente, os computadores portáteis fossem adquiridos principalmente para uso em editores de texto e planilhas, hoje é possível encontrar modelos de notebooks gamers cujo desempenho rivaliza com muitos dos melhores computadores de mesa disponíveis. Observar a evolução entre os notebooks antigos e um notebook gamer atual é impressionante, destacando a transformação significativa na capacidade de processamento ao longo do tempo.

Laptop versus notebook: Qual é o termo correto?

No contexto do nosso mercado, seria incorreto afirmar que "notebook" é uma designação inadequada para o computador portátil. Ao observarmos os primórdios dos dispositivos mencionados anteriormente, percebe-se que o termo ganhou popularidade devido à sua capacidade de ser aberto e fechado.

Entretanto, enquanto o termo "notebook" ganhou destaque no Brasil, nos Estados Unidos, a preferência é pelo termo "laptop". Assim, é completamente aceitável buscar por "notebooks" tanto em lojas físicas quanto em plataformas de comércio eletrônico. Até mesmo nós, como evidenciado na vitrine a seguir, adotamos o uso do termo mais difundido.

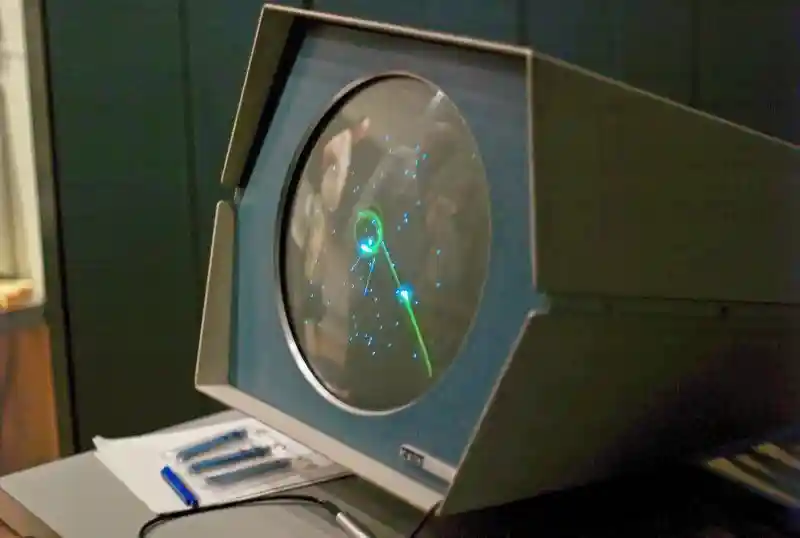

À medida que a história do primeiro computador e o desenvolvimento da informática progrediam, testemunhamos também a evolução dos primeiros jogos eletrônicos. Apesar de os primeiros computadores que ocupavam salas inteiras já conseguirem executar jogos bastante simples, o hobby era restrito a estudantes universitários e profissionais da indústria.

Spacewar! é reconhecido como o pioneiro entre os jogos de computador e foi lançado em 1961 para o modelo PDP-1. O jogo consistia em uma batalha espacial entre dois jogadores, que controlavam naves espaciais com o objetivo de derrotar um ao outro para alcançar a vitória.

- Precisa de um notebook potente pra rodar seus jogos favoritos? Veja a nossa lista de melhores notebooks gamer!

No entanto, a alegação de que o Spacewar! foi o primeiro jogo de computador ainda é objeto de contestação nos dias atuais. Onze anos antes de sua criação, um jogo chamado Bertie the Brain foi apresentado em uma convenção anual de exposições no Canadá, em 1950. Nesse jogo, os participantes desafiavam uma inteligência artificial em partidas do famoso "jogo da velha".

Apesar disso, devido à sua natureza efêmera, sendo uma atração temporária na convenção e desmontada logo após seu encerramento, o Bertie the Brain foi considerado mais uma máquina de jogos do que um jogo de computador propriamente dito. Pode ser comparado a um fliperama, mas não era considerado um jogo para computador. No entanto, é crucial notar que o Bertie the Brain foi a primeira máquina de jogos a apresentar inteligência artificial, com níveis de dificuldade programáveis.

Somente no final da década de 1970 é que os jogos de computador saíram dos laboratórios de informática americanos para os lares dos entusiastas de tecnologia. A primeira geração de jogos para computadores pessoais consistia, em sua maioria, em aventuras baseadas em texto. Posteriormente, os gráficos começaram a desempenhar um papel cada vez mais importante, combinando comandos em texto com imagens e animações gráficas.

A partir desse ponto, testemunhamos o surgimento de fenômenos como Doom, os primeiros jogos de Warcraft e Half-Life, entre muitos outros. Uma parte da história da criação de Doom é apresentada de forma envolvente no documentário da Netflix, "GDLK", com entrevistas dos criadores do jogo abordando as dificuldades e a criatividade necessárias para pioneirismo nesse tipo de jogo.

Naquela época, todo o processamento do jogo, incluindo os gráficos, era realizado exclusivamente pelo processador, que incorporava um componente chamado acelerador gráfico. Esse componente é o que conhecemos hoje como placa de vídeo onboard, ou integrada, uma característica ainda comum em notebooks não direcionados a jogos.

Fundada em 1993, a NVIDIA se destaca como a única empresa totalmente dedicada à criação de placas de vídeo dedicadas. Enquanto sua principal concorrente no mercado, a AMD, também compete na área de processadores com a Intel.

Em uma entrevista exclusiva ao Buscapé, Richard Cameron, presidente da NVIDIA no Brasil, afirmou que foram os jogos que impulsionaram a necessidade de desenvolver uma peça dedicada ao processamento gráfico. Além disso, Cameron revelou que o próprio termo GPU (Graphic Processor Unit, ou Unidade de Processamento Gráfico) foi introduzido pela NVIDIA.

Apenas dois anos após sua fundação, a NVIDIA lançou no mercado sua primeira placa de vídeo dedicada, a NV-1, equipada com 2MB de memória RAM dedicada para vídeo (agora chamada de VRAM) e compatível apenas com a primeira versão do DirectX.

Ao longo dos cerca de 25 anos desde o lançamento da NV-1, as placas de vídeo dedicadas não apenas se consolidaram como componentes cruciais para jogos, mas também para o uso em programas de edição de vídeo ou imagem. Essas placas tornaram-se parte fundamental da revolução na indústria audiovisual, contribuindo para a digitalização de processos artísticos. Sua importância é tão expressiva que o componente se tornou essencial para diversas profissões, como evidenciado por esta lista de notebooks para AutoCAD, um software de referência para arquitetos e engenheiros.

Um ponto controverso que marca este momento na história das placas de vídeo é o seu uso na mineração de criptomoedas, como Ethereum e Bitcoin, uma prática que tem se intensificado desde 2020. A mineração exige um poder computacional máximo, tornando as placas de vídeo não apenas essenciais, mas também alvo desse mercado.

O emprego de placas, originalmente projetadas para jogos, nesse contexto específico elevou significativamente o custo desses componentes, um dos fatores que contribuíram para o aumento geral dos preços. Vale ressaltar que as placas de vídeo já eram os componentes mais dispendiosos em comparação com outras peças de um computador. Em nossa conversa com Richard Cameron, ele abordou esse fenômeno.

"A maior prioridade da NVIDIA são os jogadores. Por isso, a empresa está lançando no mercado linhas de placas de vídeo específicas para a mineração de criptomoedas, denominadas CMP (Cryptocurrency Mining Processor). Apesar de possuírem a mesma capacidade de computação das placas destinadas aos jogos, elas não incluem saída de vídeo."

Em outras palavras, esse tipo de placa não pode ser conectado a um monitor gamer ou uma TV para jogos. Ainda não podemos afirmar se essa solução surtiu efeito, mas, como entusiastas de jogos, também almejamos uma redução nos preços das placas de vídeo!

Ao longo da trajetória da informática, as tendências são evidentes: os computadores se tornam cada vez menores e mais poderosos. Isso é evidenciado pelos smartphones e smartwatches, que incorporam processadores, telas e sistemas operacionais. Entretanto, e se eu lhe dissesse que o futuro da informática pode estar no tamanho molecular?

Essa é a visão compartilhada pelo Dr. Luciano Silva, coordenador do curso de Ciência da Computação na Universidade Presbiteriana Mackenzie. Com pesquisas em Astroinformática e Computação de Alto Desempenho, ele revelou que já existem métodos para programar bactérias, utilizando-as para iluminar áreas dos oceanos contaminadas por petróleo, por exemplo.

É claro que essa tecnologia provavelmente permanecerá restrita ao âmbito acadêmico por um bom tempo. No entanto, esse não é o único caminho vislumbrado para o futuro da informática.

De fato, podemos considerar que a computação quântica já está presente, uma vez que é possível acessar um ambiente de programação quântica gratuitamente por meio da nuvem da Microsoft e da IBM. Durante nossa conversa, o Dr. Luciano mencionou que o que torna a computação quântica tão extraordinária é o fato de ela não utilizar o modelo binário criado por Alan Turing, presente nos computadores até os dias atuais.

Em outras palavras, os computadores quânticos não realizam cálculos com valores 0 ou 1, mas sim com ambos simultaneamente. Isso permite a execução de cálculos de maneira incrivelmente rápida, representando uma ruptura de paradigma semelhante ao que ocorreu na década de 1940 com o ENIAC.

Para o futuro dos computadores, além das perspectivas acadêmicas, conversamos com executivos da indústria para entender suas visões, mesmo para um futuro próximo. Richard Cameron, presidente da NVIDIA no Brasil, compartilhou que o sonho para a reprodução gráfica é atingir uma fidelidade tão precisa que se torne impossível distinguir o que é real do que é gerado por uma placa de vídeo. Ele também enxerga um futuro na computação gráfica em nuvem, exemplificado pelo serviço GeForce Now.

O serviço da NVIDIA permite o acesso remoto a servidores da empresa para desfrutar de jogos da biblioteca da Steam com alta qualidade, incluindo tecnologias avançadas como Ray Tracing e DLSS 2.0. Luciano Beraldo, gerente da área de notebooks da Samsung no Brasil, expressou sua expectativa de que os notebooks evoluam para se tornarem dispositivos mais leves e adaptáveis, com ênfase na conectividade aprimorada com outros dispositivos inteligentes.

Ele destaca a importância da conectividade em ambientes automatizados e prevê melhorias nas conexões nos próximos anos. A plataforma SmartThings da Samsung, que integra o conceito de Internet das Coisas, exemplifica essa abordagem, proporcionando conectividade e atuando como um controle remoto para aparelhos inteligentes Samsung via smartphone.

Com base nas pesquisas e conversas, duas tendências se destacam: a conectividade entre dispositivos e a computação em nuvem estão se tornando elementos transformadores em nossa relação com os computadores. A possibilidade de desfrutar de jogos avançados em servidores remotos, a utilização de computadores quânticos sem custos e a capacidade de levar notebooks para qualquer lugar já são realidades presentes e apontam para um futuro mais conectado, acessível e repleto de possibilidades de evolução em nossas capacidades de descoberta.

Fontes:

- https://www.britannica.com/biography/Charles-Babbage

- http://www.ime.unicamp.br/~apmat/ada-lovelace/

- https://www.newtoncbraga.com.br/index.php/curiosidades/4856-cur008

- https://www.livescience.com/20718-computer-history.html

- https://slate.com/culture/2014/12/the-imitation-game-fact-vs-fiction-how-true-the-new-movie-is-to-alan-turings-real-life-story.htmlhttps://www.britannica.com/biography/Alan-Turing

- https://time.com/3609585/the-true-story-of-the-imitation-game/

- https://www.historyofinformation.com/detail.php?id=623#:~:text=Stibitz's%20%22Model%20K%22%20(for,the%20Bell%20Labs%20Model%20I)

- https://history-computer.com/george-stibitz/

- https://en.wikipedia.org/wiki/George_Stibitz

- https://www.britannica.com/technology/ENIAC

- https://www.computerhistory.org/revolution/birth-of-the-computer/4/78#:~:text=In%201942%2C%20physicist%20John%20Mauchly,an%20all%2Delectronic%20calculating%20machine.&text=The%20result%20was%20ENIAC%20(Electronic,slowed%20by%20any%20mechanical%20parts

- https://www.computerhistory.org/timeline/1971/#169ebbe2ad45559efbc6eb35720a58a7

- https://www.ibm.com/ibm/history/exhibits/pc25/pc25_birth.html

- https://lowendmac.com/2006/origin-of-the-ibm-pc/

- https://apple2history.org/2010/10/25/the-competition-part-2/

- https://agenciabrasil.ebc.com.br/radioagencia-nacional/acervo/pesquisa-e-inovacao/audio/2018-07/historia-hoje-primeiro-computador-brasileiro-foi-criado-na-usp-ha/#:~:text=Em%2024%20de%20julho%20de,projetistas%20de%20o%20Patinho%20Feio.

- http://www.scielo.br/scielo.php?script=sci_arttext&pid=S0034-75901988000300012

- https://www.computerhope.com/history/laptop.htm#:~:text=Developed%20by%20Adam%20Osborne%20in,and%20had%20a%205%22%20display.&text=Epson%20released%20the%20Epson%20HX,with%20a%20built%2Din%20printer

- https://www.tecmundo.com.br/internet/2231-a-historia-dos-notebooks.htm

- https://www.thoughtco.com/history-of-laptop-computers-4066247

- https://plarium.com/en/blog/the-first-video-game/

- https://technical.city/pt/video/NV1

Agora que já sabe mais sobre computadores, que tal comprar um e receber parte do seu dinheiro de volta com o programa de Cashback do Shopping do PAN? Ao efetuar compras através do Shopping do Pan, uma porcentagem do valor gasto retorna para você.

Se você for correntista do Banco Pan, ganha cashback diferenciado! Baixe o aplicativo do Banco PAN e abra sua conta!